导语:就在今天凌晨,OpenAI 马不停蹄地又双叒叕更新啦! 这一次,不仅重磅升级了 ChatGPT 背后的 GPT-3.5-turbo 模型、以及最先进的 GPT-4 文本生成模型,而且大幅降低了价格,另外还为 gpt-3.5-turbo 提供 16000 个 Token 的语境窗口(Context Window)上下文...

就在今天凌晨,OpenAI 马不停蹄地又双叒叕更新啦!

这一次,不仅重磅升级了 ChatGPT 背后的 GPT-3.5-turbo 模型、以及最先进的 GPT-4 文本生成模型,而且大幅降低了价格,另外还为 gpt-3.5-turbo 提供 16000 个 Token 的语境窗口(Context Window)上下文选项。

一、更新速览

详细来看,在今天的更新中,OpenAI 主要聚焦在下面几个维度:

全新的 16k 上下文 GPT-3.5-Turbo 模型版本(今天向所有人提供)

升级版的 GPT-4 和 GPT-3.5-Turbo 模型

Chat Completions API 中的新函数调用功能

最先进的 V2 嵌入模型降价 75%

gpt-3.5-turbo 的输入 Token 成本降低 25%

宣布 gpt-3.5-turbo-0301 和 gpt-4-0314 模型的淘汰时间表

GPT-4 的 API 权限将开放给更多的人

值得一提的是,OpenAI 再次重申,所有这些模型都具备 OpenAI 在 3 月 1 日推出的数据隐私和安全保证--用户从他们的请求中产生的所有输出,以及 API 数据都不会被用于训练。

据 OpenAI 公告显示,最新的 gpt-4-0613 版本包括一个带函数调用的更新和改进的模型。

gpt-4-32k-0613 包括与 gpt-4-0613 相同的改进,同时扩展了上下文长度,以便更好地理解更大的文本。

有了这些更新,在未来几周内,OpenAI 表示将会邀请更多候补名单上的人试用 GPT-4,目的是通过这个模型完全取消等待名单。

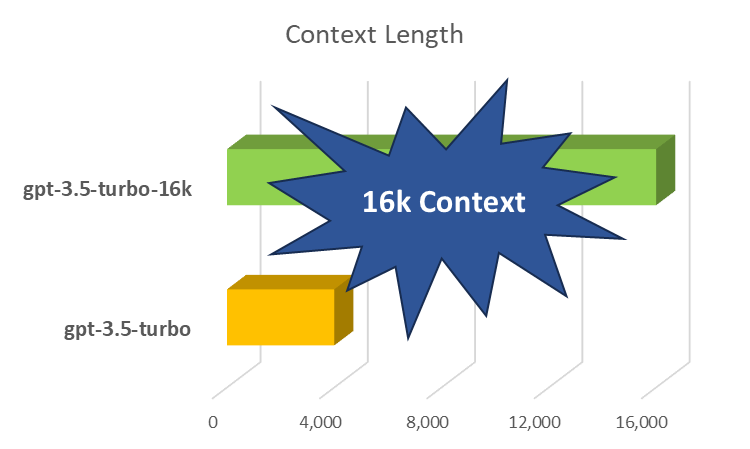

三、GPT-3.5-turbo-16k 大更新

事实上,在大型语言模型(LLMs)中,"语境窗口"(Context Window)就像一个短期存储器,存储着提示输入的内容,或者在聊天机器人的情况下,存储着正在进行的对话的全部内容。在语言模型中,增加语境大小已经成为一场技术竞赛,Anthropic 最近宣布为其 Claude 语言模型提供 75000 个语境窗口选项。此外,OpenAI 已经开发了一个 32,000 个 Token 的 GPT-4 版本,但它还没有公开提供。

在今天的最新更新中,OpenAI 推出了 gpt-3.5-turbo 的新的 16000 个上下文语境窗口版本,官方名称叫做:gpt-3.5-turbo-16k,允许一个提示的长度达到 16000 个 Token。

来源:https://twitter.com/minchoi/status/1668738225567875072

来源:https://twitter.com/minchoi/status/1668738225567875072

由于它提供了 4 倍于 gpt-3.5-turbo 的上下文长度,这意味着 gpt-3.5-turbo-16k 模型现在可以在一次请求中支持 20 页的文本。

这对于需要模型处理和生成较大块文本响应的开发者来说是一个相当大的提升。

不过,想要广泛使用还需要再等一等。

再者,gpt-3.5-turbo-0613 版本与 GPT-4 一样有着函数调用功能,以及通过系统消息提供的更可靠的可引导性,这两个特性使开发者能够更有效地引导模型的响应。

四、函数调用支持新版 GPT-4 和 GPT-3.5

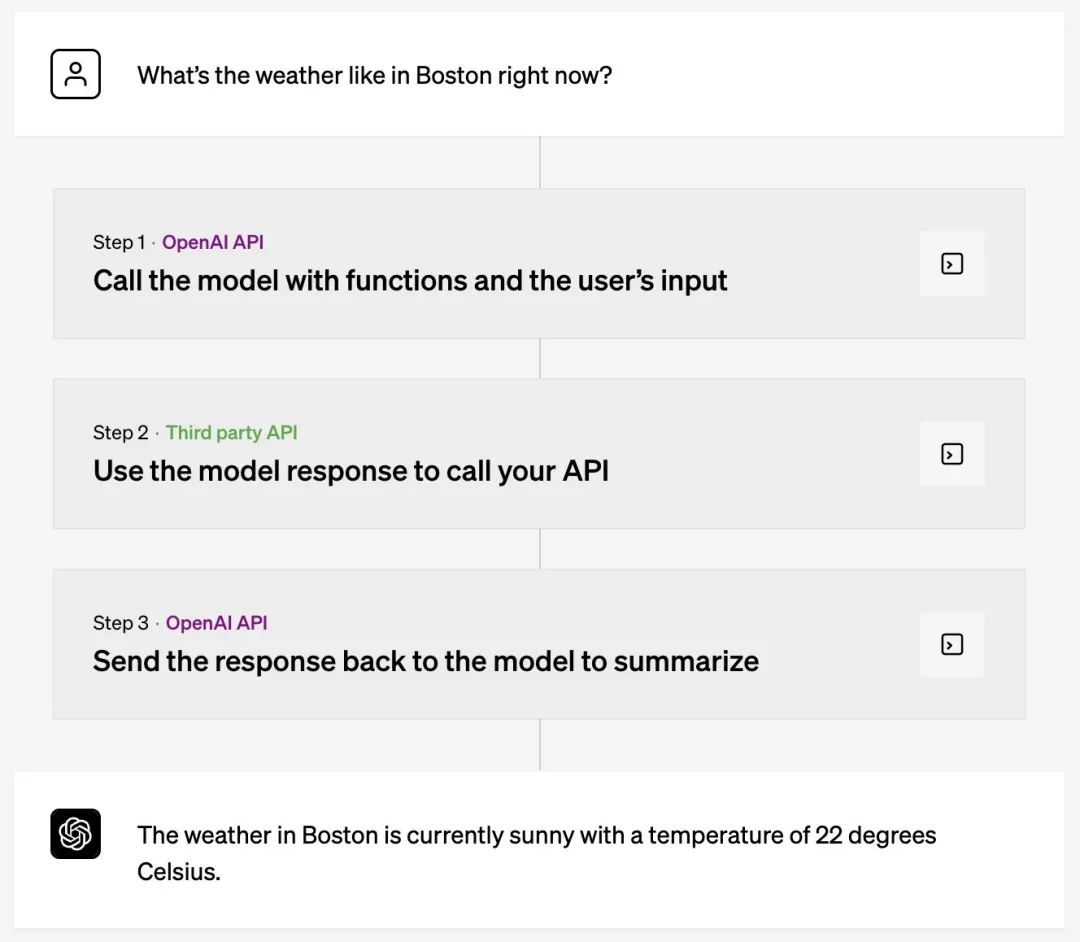

要论最最最为重磅的更新,便是开发者现在可以向 gpt-4-0613 和 gpt-3.5-turbo-0613 描述函数,并让模型智能地选择输出一个包含参数的 JSON 对象来调用这些函数。

这是一种全新的方式,开发者可以更可靠地将 GPT 的能力与外部工具和 API 连接起来。

简单来看,OpenAI 联合创始人Greg Brockman 解释道,这是插件的底层机制,允许开发者与自己的工具集成起来:

那该具体怎么用?

OpenAI 举了三个例子,其表示,这些模型已经过微调,既可以检测到何时需要调用一个函数(取决于用户的输入),又可以用符合函数签名的 JSON 来响应。函数调用允许开发人员更可靠地从模型中获得结构化的数据。

例如,开发人员可以:

创建聊天机器人,通过调用外部工具(例如,像 ChatGPT 插件)来回答问题

将诸如 "给 Anya 发邮件,看她下周五是否想喝咖啡 "这样的查询转换为send_email(to: string, body: string)这样的函数调用。

或者将 "波士顿的天气如何?"转换为 get_current_weather(location: string, unit: 'celsius' | 'fahrenheit')。

将自然语言转换为 API 调用或数据库查询

将 "谁是我这个月的十大客户?"转换为内部 API 调用,如 get_customers_by_revenue(start_date: string, end_date: string, limit: int)。

或将 "Acme, Inc.上个月有多少订单?"转换成 SQL 查询,使用sql_query(query: string)。

从文本中提取结构化数据

定义一个名为 extract_people_data(people: [{name: string, birthday: string, location: string}] 的函数,以提取维基百科文章中提到的所有人物。

这些用例是由 OpenAI 的 /v1/chat/completions 端点中的新 API 参数 functions 和 function_call 促成的,它允许开发者通过 JSON Schema 向模型描述功能,并可选择要求它调用一个特定的功能。

1000.jpg

1000.jpg

如果,现在你有 GPT-4 访问权限,那么这些模型可以用函数调用功能。

五、旧模型即将废弃

今天,OpenAI 将开始对 3 月份宣布的 gpt-4 和 gpt-3.5-turbo 的初始版本进行升级和废弃处理。使用稳定模型名称(gpt-3.5-turbo、gpt-4 和 gpt-4-32k)的应用程序将在 6 月 27 日自动升级到上面列出的新模型。

为了比较不同版本的模型性能,OpenAI 还提供开源的 Evals 库(https://github.com/openai/evals)支持公共和私人评估 LLM,帮助开发者评测模型的变化将如何影响你的用例。

当然,对于需要更多时间过渡的开发者,OpenAI 也表示,可以继续使用旧的模型。这些旧型号将在 9 月 13 日之后,彻底弃用。

六、加量不加价,即日起生效

除了以上功能更新之外,OpenAI 宣布下调价格,即日起生效。

首先,对于 OpenAI 最受欢迎的嵌入模型——text-embedding-ada-002,OpenAI 将成本降低 75%,至每 1K Token 是 0.0001 美元。

其次,对于最受欢迎的聊天模型——GPT-3.5 Turbo,OpenAI 将输入 Token 的成本直降 25%,现在每 1K 输入 Token 只需 0.0015 美元,每 1K 输出 token 只需 0.002 美元,这相当于 1 美元大约有 700 页的文本。

再者,最新推出的 gpt-3.5-turbo-16k 的价格是每 1K 输入 token 是 0.003 美元,每 1K 输出 Token 为 0.004 美元。

OpenAI 表示,降低成本是通过提高其系统的效率来实现的。毫无疑问,这是初创公司关注的关键领域,因为它在研发和基础设施上花费了数亿美元。

七、一骑绝尘的 OpenAI

OpenAI 已经表示,在 4 月初 GPT-4 发布之后,会对现有模型的增量更新,而不是大规模的从头开始的新模型开发。在最近由《经济时报》主办的一次会议上,OpenAI CEO Sam Altman 也重申过,OpenAI 尚未开始培训 GPT-4 的继任者,这也侧面意味着该公司在开始新模型之前“还有很多工作要做”。如今便是维护已发布模型的一大进步。

当然,这一进步也受到了不少网友的点赞:

当然,OpenAI 的快跑也给做大模型的同行带来了巨大的压力,有网友评论道:

对此,你最看好哪个更新?最新的 GPT-4 和 GPT-3.5-turbo 模型,还是 16k context turbo 模型?